BTC/HKD+0.71%

BTC/HKD+0.71% ETH/HKD+0.8%

ETH/HKD+0.8% LTC/HKD-0.46%

LTC/HKD-0.46% ADA/HKD-0.22%

ADA/HKD-0.22% SOL/HKD+1.52%

SOL/HKD+1.52% XRP/HKD+0.5%

XRP/HKD+0.5%撰文:Tanya Malhotra

來源:Marktechpost

編譯:DeFi 之道

圖片來源:由無界版圖AI工具生成

隨著生成性人工智能在過去幾個月的巨大成功,大型語言模型(LLM)正在不斷改進。這些模型正在為一些值得注意的經濟和社會轉型做出貢獻。OpenAI 開發的 ChatGPT 是一個自然語言處理模型,允許用戶生成有意義的文本。不僅如此,它還可以回答問題,總結長段落,編寫代碼和電子郵件等。其他語言模型,如 Pathways 語言模型(PaLM)、Chinchilla 等,在模仿人類方面也有很好的表現。

BitTorrent Chain 主網即將上線并實施 BTT 拆分計劃:據官方消息,BitTorrent Chain 主網預計將于 2021年12月12日 正式上線,并實施 BTT 拆分計劃。 BTT 代幣總市值不變的基礎上,將總發行量從 990,000,000,000 枚調整為 990,000,000,000,000 枚,拆分比例為 1 : 1000。拆分后的新幣為BTT,舊 BTT 代幣更名為 BTTOLD。

BitTorrent Chain 是首個異構鏈跨鏈互操作擴容協議,采用 POS(Proof of Stake)共識機制 ,通過側鏈進行智能合約的擴展。首發支持 Ethereum 、TRON 、BSC 公鏈跨鏈,未來將逐步支持更多公鏈。[2021/12/6 12:55:06]

大型語言模型使用強化學習(reinforcement learning,RL)來進行微調。強化學習是一種基于獎勵系統的反饋驅動的機器學習方法。代理(agent)通過完成某些任務并觀察這些行動的結果來學習在一個環境中的表現。代理在很好地完成一個任務后會得到積極的反饋,而完成地不好則會有相應的懲罰。像 ChatGPT 這樣的 LLM 表現出的卓越性能都要歸功于強化學習。

美CFTC主席:Michael Conaway提交的《數字商品交易法》可為21世紀的商品提供更多機遇:此前消息,美國國會眾議員Michael Conaway于周四提出2020年《數字商品交易法》,旨在為“數字商品交易所”指定聯邦定義,并指定美國商品期貨交易委員會(CFTC)對其進行監督。

CFTC主席Heath Tarbert隨后轉發該法案并表示:“感謝Michael Conaway在數字監管領域的杰出領導作用。隨著我們繼續邁向數字世界,這項法院將有助于為21世紀的商品提供更多機遇。”[2020/9/25]

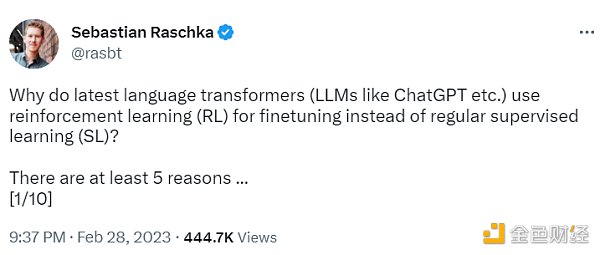

ChatGPT 使用來自人類反饋的強化學習(RLHF),通過最小化偏差對模型進行微調。但為什么不是監督學習(Supervised learning,SL)呢?一個基本的強化學習范式由用于訓練模型的標簽組成。但是為什么這些標簽不能直接用于監督學習方法呢?人工智能和機器學習研究員 Sebastian Raschka 在他的推特上分享了一些原因,即為什么強化學習被用于微調而不是監督學習。

聲音 | nChain的首席執行官:24號BSV推出的Quasar升級版網絡將提高礦工盈利能力:BSV計劃于7月24日推出名為Quasar的升級版網絡。該升級計劃的唯一更改是提升默認區塊大小上限。nChain的首席執行官Jimmy Nguyen近日評論了Quasar升級將如何幫助比特幣礦工,他表示,“礦工需要意識到大規模擴張對提高他們的盈利能力至關重要,特別是在2020年5月塊獎勵減半之后。為了礦業保持盈利,礦工需要從每個區塊賺取更多的交易費用以補償較低的區塊獎勵補貼,這只能在BSV上進行。在2019年5月21日BSV Scaling測試網絡測試期間,開采了一塊1.42GB的塊, 這導致交易費首次超過獎勵補貼。這就是中本聰一直設想的比特幣的運作經濟模式,確保礦工保持盈利。“[2019/7/19]

動態 | Chainalysis籌集600萬美元資金,三菱UFJ金融集團參與:據路透社消息,4月16日,加密貨幣交易分析公司Chainalysis宣布,已從日本三菱UFJ金融集團、風險投資公司Sozo Ventures籌集600萬美元資金,進一步擴展其亞洲業務。此外,其首席執行官Michael Gronager表示考慮明年在日本開設辦事處。(注:今年2月,Chainalysis完成3000萬美元的B輪融資,由風險投資公司Accel領投,Benchmark參投。)[2019/4/16]

不使用監督學習的第一個原因是,它只預測等級,不會產生連貫的反應;該模型只是學習給與訓練集相似的反應打上高分,即使它們是不連貫的。另一方面,RLHF 則被訓練來估計產生反應的質量,而不僅僅是排名分數。

Sebastian Raschka 分享了使用監督學習將任務重新表述為一個受限的優化問題的想法。損失函數結合了輸出文本損失和獎勵分數項。這將使生成的響應和排名的質量更高。但這種方法只有在目標正確產生問題-答案對時才能成功。但是累積獎勵對于實現用戶和 ChatGPT 之間的連貫對話也是必要的,而監督學習無法提供這種獎勵。

不選擇 SL 的第三個原因是,它使用交叉熵來優化標記級的損失。雖然在文本段落的標記水平上,改變反應中的個別單詞可能對整體損失只有很小的影響,但如果一個單詞被否定,產生連貫性對話的復雜任務可能會完全改變上下文。因此,僅僅依靠 SL 是不夠的,RLHF 對于考慮整個對話的背景和連貫性是必要的。

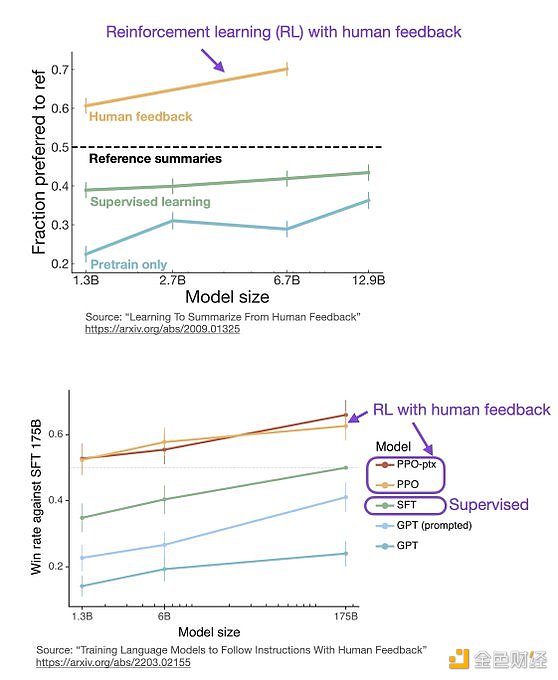

監督學習可以用來訓練一個模型,但根據經驗發現 RLHF 往往表現得更好。2022 年的一篇論文《從人類反饋中學習總結》顯示,RLHF 比 SL 表現得更好。原因是 RLHF 考慮了連貫性對話的累積獎勵,而 SL 由于其文本段落級的損失函數而未能很好做到這一點。

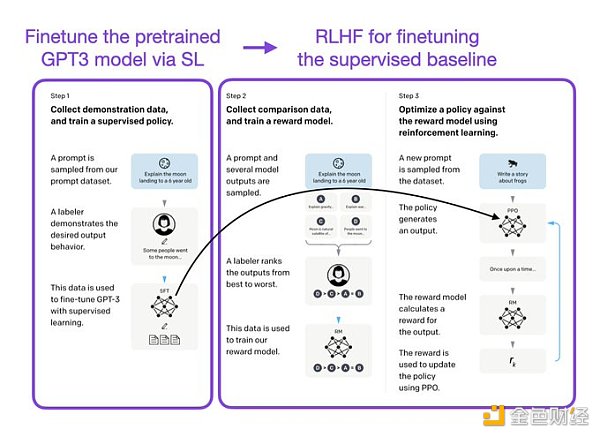

像 InstructGPT 和 ChatGPT 這樣的 LLMs 同時使用監督學習和強化學習。這兩者的結合對于實現最佳性能至關重要。在這些模型中,首先使用 SL 對模型進行微調,然后使用 RL 進一步更新。SL 階段允許模型學習任務的基本結構和內容,而 RLHF 階段則完善模型的反應以提高準確性。

DeFi之道

個人專欄

閱讀更多

金色財經 善歐巴

金色早8點

Odaily星球日報

歐科云鏈

Arcane Labs

MarsBit

深潮TechFlow

BTCStudy

澎湃新聞

Tags:CHAAINHAIChainDSK Chainplugchain幣是那國發行的blockchain是什么錢包realmedicinesupplychain

文/ William M. Peaster,Bankless作者;譯/金色財經xiaozou2023年2月28日.

1900/1/1 0:00:00我們要感謝 Polygon Zero 團隊、Consensys gnark 項目、Pado Labs 和 Delphinus Lab 團隊對本篇文章的寶貴評論和反饋.

1900/1/1 0:00:00來源:Aaron推文 編譯:念青,ChainCatcher由于空投預期,Blur 的熱度一直在持續.

1900/1/1 0:00:00香港證監會行政總裁:加密貨幣平臺是整個Web3.0生態的一部分:金色財經報道,香港證監會行政總裁梁鳳儀在博鰲亞洲論壇2023年年會“ESG投資如何行穩致遠”分論壇后的問答環節時表示.

1900/1/1 0:00:003月6日,波場TRON隆重宣布與多米尼克國達成最新合作,共同開啟Web 3.0新紀元。波場TRON將發展加勒比地區首個數字身份計劃,包括搭建多米尼克元宇宙、運營多米尼克數字身份(DDID)項目及.

1900/1/1 0:00:00Eigenlayer是能夠至少延續到24年的新敘事,作為主打ETH“共享安全”的重大創新,其提出的LSD流動性代幣的再質押方案,具有多條敘事邏輯加持.

1900/1/1 0:00:00