BTC/HKD+0.26%

BTC/HKD+0.26% ETH/HKD-0.38%

ETH/HKD-0.38% LTC/HKD-0.17%

LTC/HKD-0.17% ADA/HKD-1.41%

ADA/HKD-1.41% SOL/HKD+0.89%

SOL/HKD+0.89% XRP/HKD-0.77%

XRP/HKD-0.77%來源:新智元編輯:Aeneas好困

快速定制模型的LLM引擎Lamini來了,開發者狂喜!

ChatGPT雖好,但始終有門檻。通常,只有擁有AI博士學位的大型機器學習團隊,才能這樣訓練一個模型。

為了把這個門檻打下來,團隊構建了Lamini引擎,從此,每個開發者都能夠擁有從GPT-3訓練ChatGPT的超能力!

劃重點:可以商用!可以商用!可以商用!

項目地址:https://github.com/lamini-ai/lamini/

Lamini的開發團隊表示,你需要的只是幾行代碼,就可以用托管數據生成器倆訓練自己的LLM,包括權重和其他所有的內容。

此外,你也可以使用開源的LLM,用Lamini庫對生成的數據進行微調。以及訪問完整的LLM訓練模塊,使用從LoRa等速度優化,到虛擬私有云(VPC)部署等企業功能。

對此,英偉達科學家JimFan表示,LLaMa+自定義數據正在成為新的范式,而Lamini的推出也帶了一種全新的模式——FaaS,微調即服務。

Arbitrum公布定序器故障報告:用戶資金安全,將創建Arbitrum網絡狀態頁面:6月10日消息,Arbitrum 基金會官方公布此前 Sequencer(定序器)Bug 處理的事后分析文檔,解釋了 Sequencer 批處理問題的原因,其中主要提到三點重要事項:1、Sequencer 沒有宕機或耗盡資金;2、Sequencer 會繼續接受用戶交易;3、用戶資金沒有面臨任何風險。[2023/6/10 21:27:38]

MLOps的未來是「LMOps」。哪里有標準化,哪里就有機會。

OpenAI科學家,前特斯拉人工智能總監AndrejKarpathy也表示,LLM定制化的生態正在愈發火爆。

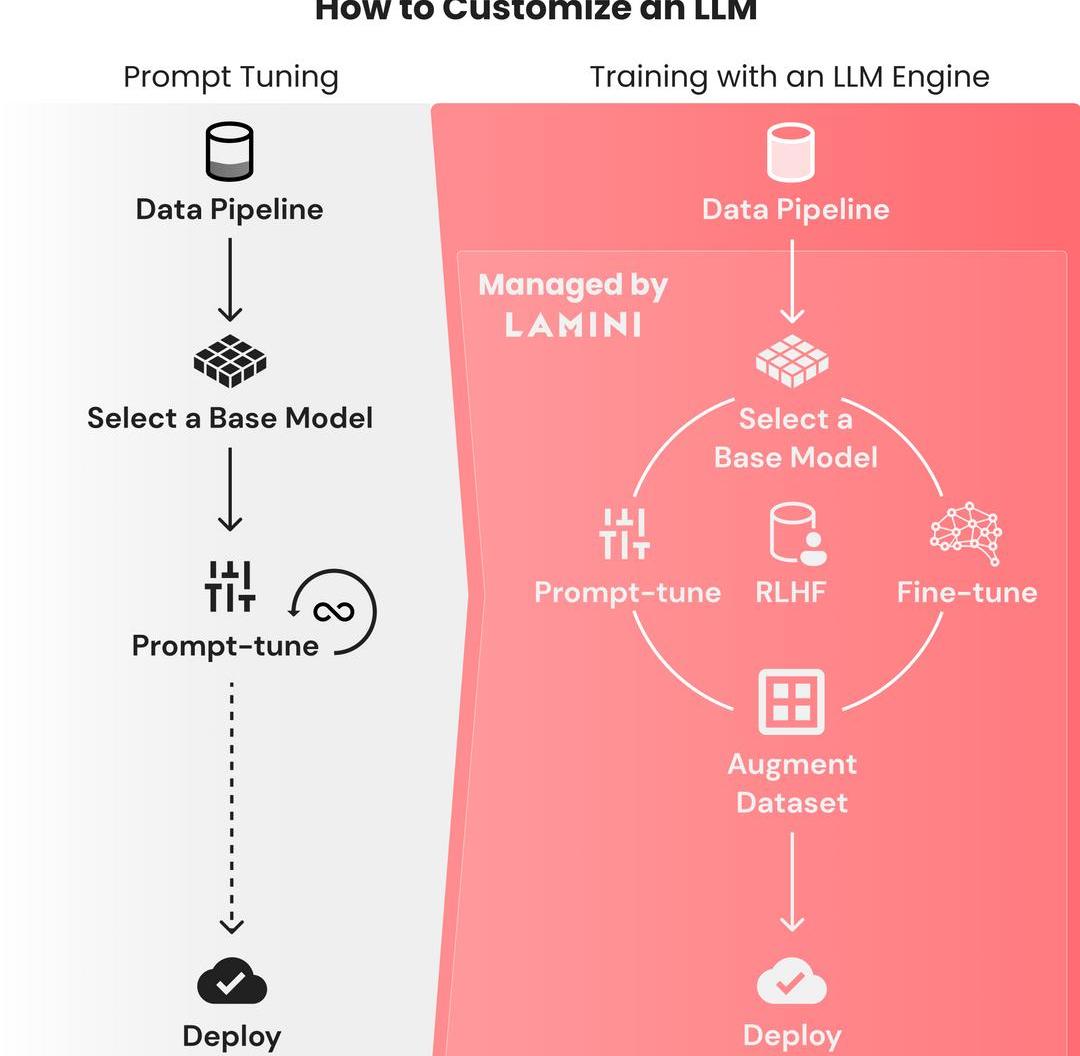

訓LLM就像prompt-tuning一樣簡單

寫一個prompt如此容易,但想要從基礎模型訓練出一個大語言模型,卻是如此困難。

因為需要花費大量時間,來找出微調模型失敗的原因,所以對數據集微調的迭代周期都是以月為單位的。

與之相反,微調prompt的迭代,只需要幾秒鐘,并且在幾個小時內,性能都能保持穩定。

這個過程只需要把有限數量的數據整合到prompt中就可以了,并不需要動輒幾TB的數據。

ChatGPT的誕生十分艱難,OpenAI的團隊花了幾個月的時間,在基礎的GPT-3模型上微調,并進行RLHF。這個門檻極高,只有大型的ML團隊才能完成這種訓練。

Consensys發布《ETH質押提款指南》并推薦選擇部分提款,屆時將推出紀念NFT:3月8日消息,Consensys發布《ETH質押提款指南》,指南中提到,Shanghai/Capella升級的主要成果是允許質押者提取他們質押的ETH,但更具體地說,它將提供與提款相關的三個關鍵功能:1.能夠將以太坊驗證器的取款憑證從舊的0x00類型(源自BLS密鑰)更新為較新的0x01類型(源自以太坊地址)。2.部分提款,或從活躍驗證者的余額(超過32 ETH)中定期自動“退出”獲得的共識層獎勵。3.全額提款,或收回“退出”驗證者的全部余額。只有具有較新的0x01類型提款憑證的驗證者才有資格進行部分和全部提款,然而,目前還沒有這樣做的必要,因為0x00認證的驗證者將繼續像信標鏈誕生以來那樣獲得獎勵。請注意,一旦驗證者將其取款憑證從0x00類型更新為0x01類型,就無法再更改。這是從0x00到0x01類型的提款憑證的一次性單向更改。

部分提款使質押者受益,因為質押者可以定期訪問他們的驗證者獲得的CL質押獎勵(扣除任何罰款),而不會產生任何gas成本,也不必退出他們的驗證者。此外,由于以太坊驗證者的有效余額上限為32 ETH,因此驗證者余額上的任何剩余ETH都是無用的。部分提款允許質押者訪問這些過剩的、非生產性的ETH,并將其重新部署以激活新的以太坊驗證器或其他地方。部分提款也應該通過防止過長的退出隊列和過多的驗證者流失而使以太坊網絡受益,這可能會破壞網絡的穩定性。

目前,58%的人擁有0x00類型的取款憑據。在剩下的42%中,使用0x01類型的取款憑證,大約61%(或所有以太坊驗證器的25%)由Lido驗證器集操作。

此外,為慶祝升級,ConsenSys將在3月下旬/4月中旬升級上線時推出其第二個紀念NFT系列,并邀請Web3愛好者通過領取NFT參與。[2023/3/8 12:48:49]

有500強企業的技術負責人這樣抱怨過:「我們團隊的10名機器學習工程師用了OpenAI的微調API,結果我們的模型反而變得更差了,怎么辦啊。」

美國參議院通過規模為4300億美元通脹削減法案:8月8日消息,美國參議院通過規模為4300億美元通脹削減法案,美國總統拜登對此表示,眾議院應該盡快該法案,期待著將其簽署成為法律。

美國參議院通過民主黨的通脹削減法案,美國參議院通過了一項具有里程碑意義的稅收、氣候和醫療保健法案(通脹削減法案)。該法案的投票結果是51名民主黨人贊成50名共和黨人反對,美國副總統哈里斯做出了打破僵局的投票。目前,該法案已提交眾議院,預計將于周五通過。民主黨稱該法案是美國應對氣候變化的最大投資,還旨在防止大公司利用稅收漏洞,并將首次允許聯邦醫療保險(Medicare)就藥品價格進行談判。預計法案還將在未來10年進行大幅度的預算赤字削減。共和黨人一致反對,認為法案無法削減處于歷史高位的通脹水平,而且征稅可能會使美國經濟陷入衰退。該法案的規模從最初的6萬億美元削減至約4370億美元。(金十)[2022/8/8 12:08:27]

「我真的不知道該怎么充分利用數據,我已經用盡了所有從在線教程中能學到的prompt魔法了。」

這,就是研究者構建Lamini的原因:讓每個開發者可以直接從GPT-3訓練ChatGPT。

任意LLM,秒變ChatGPT!

Lamini是一個LLM引擎,可以讓不僅僅是機器學習專家的任何開發人員,都能在大型數據集中,把高性能的LLM訓練得像ChatGPT一樣好。

這個過程,只需要Laimini庫的幾行代碼即可。

值得注意的是,這個庫中的優化遠遠超出了現在開發者可以使用的范圍,從更具挑戰性的優化到更簡單的優化。

比如,你想從不同的角度生成一個廣告文案。

Cion Digita任命Sundar Nagarathnam為首席運營官:金色財經報道,加密基礎設施初創公司Cion Digital 今天宣布任命高級執行官 Sundar Nagarathnam 為首席運營官 (COO)。Cion Digital創始人兼首席執行官Snehal Fulzele 表示,Sundar 在推動各個領域的創新和轉型方面取得了可衡量的成果,這是不言而喻的,我很高興歡迎他加入團隊。隨著我們擴展到不同的行業和市場,他深入的知識和專業知識將在確保順利、無縫的客戶入職和卓越運營方面發揮關鍵作用。[2022/6/25 1:30:39]

首先,從llama模塊導入LLM引擎:

fromllamaimportLLMllm=LLM(name="marketing")

接下來,需要定義輸入和輸出類型。注意,這里一定要包括上下文,因為可以有助于LLM在自然語言中進行理解。

fromllamaimportType,ContextclassAdAspects(Type):tone:str=Context("toneofthemarketingcopy")product_features:list=Context("productfeaturestopromote")audience:str=Context("targetaudienceforthemessage")subject:str=Context("subjectortopicofthemessage")goal:str=Context("goalofthismarketingcampaignandmessage")classAdCopy(Type):title:str=Context("googleadtitletag")description:str=Context("googleaddescription")keywords:list=Context("keywordsforthesearchengine")

觀點:Web3 身份價值和權益的增長,將推動鏈上生態更高頻次爆發:5月26日,Blocklike 以Web3 價值風口漫談為主題,圍繞 Web3 技術底層、價值生態構建和用戶協同等方面開展 圓桌直播。活動邀請 GEMS、Cassava、Blocksport、Canoe Finance、Parsiq/IQ Protocol、Film Token,共同探討 Web3 實現的長期路徑和價值潛力。

圓桌上,嘉賓們從 Web3 的愿景、技術底層、生態價值體系等角度闡述自己的洞察。嘉賓們認為,Web3 以去中心化、開放、分布式、自治管理為普遍認知,利用公鏈、協議、跨鏈等基礎設施和 DID、零知識證明等技術,重建數字世界的各種連接、服務和數據訪問,讓用戶擁有自己的身份以及影響力,實現價值自由流動和平等協作。無論 Web3 賽道和風向怎樣變化,最終的趨勢都是圍繞用戶價值重構這一本質特征進行發展。Web3 身份價值和權益的增長,將推動鏈上生態更高頻次爆發,最大化發揮區塊鏈的應用潛力。[2022/5/27 3:46:07]

然后就可以開始提問了:

語氣:大膽,但不傲慢

特色:亞洲醬料和香料、家常調料和套餐包,可以輕松在家烹飪。

aspects=AdAspects(tone="boldandbright,butnotarrogant",product_features=,audience="suburbanfamilies",subject="deliciousasianmealswithoutgoingtoarestaurant",goal="getsuburbanmomsanddadstotrybuytheirfirstomsompackorfreetastingkit")ad_copy=llm(input=aspects,output_type=AdCopy)print(f"Adcopy:{ad_copy}")模型輸出:

嘗試Omsom的美味亞洲醬料、香料、家常調料和套餐包。輕松為家人在家做出美味佳肴。

>title='DeliciousAsianMealsWithoutGoingtoaRestaurant|Omsom'description="TryOmsom'sdeliciousAsiansauces,aromatics,andhome-cookedseasoningsandmealpacks.Easilycookdeliciousmealsathomeforyourfamily."keywords=

如何創建自己的「ChatGPT」

基礎模型能理解一般的英語,但如果需要它們學習一些垂直語言和規則,prompt微調并不足夠,很多時候我們都需要構建自己的LLM。

利用用下面這個步驟,就能獲得像ChatGPT一樣遵循指令的LLM。

嘗試prompt-tuningChatGPT或其他模型

可以使用Lamini庫的API,在不同模型之間快速進行prompt-tuning,只需一行代碼,即可在OpenAI和開源模型之間切換。

Lamini庫已經優化了正確的prompt,這樣開發者就可以使用不同的模型,不必擔心如何為每個模型設置prompt的格式。

構建一個包含輸入-輸出對的大型數據集

這些數據集會向模型展示,它應該如何響應輸入,無論是遵循英文說明,還是以JSON響應。

研究者剛剛發布了一個只有幾行代碼的repo,使用Lamini庫,僅從100個數據點中,就能生成50k數據點。

而且因為使用Lamini庫來啟動Lamini引擎,所以這個過程根本不需要用到GPU。

在repo中,已經包含一個開源的70+k數據集。

項目地址:https://github.com/lamini-ai/lamini/

在大型數據集上微調基礎模型

除了數據生成器,研究者還發布了一個LLM,它使用Lamini對生成的數據進行了微調。以編程方式執行此操作的功能也會很快發布。

也可以把OpenAI的微調API作為起步。

在微調模型上進行RLHF

使用Lamini,就不再需要大型ML和人工標記團隊來運行RLHF。

部署到云端

只需點擊產品或功能中的API端點即可。

專為LLM打造的數據生成器

簡單來說,依照以下幾個步驟,就可以訓練自己的大語言模型了。

用于優化prompt微調和類型化輸出的Lamini庫。

用于微調和RLHF的高級Lamini庫,只需幾行代碼。

史上首個托管數據生成器,用于創建數據,來訓練遵循指令的LLM。注意,已獲得商業使用許可!

開源的指令跟隨LLM,使用上述工具,只需幾行代碼即可完成。

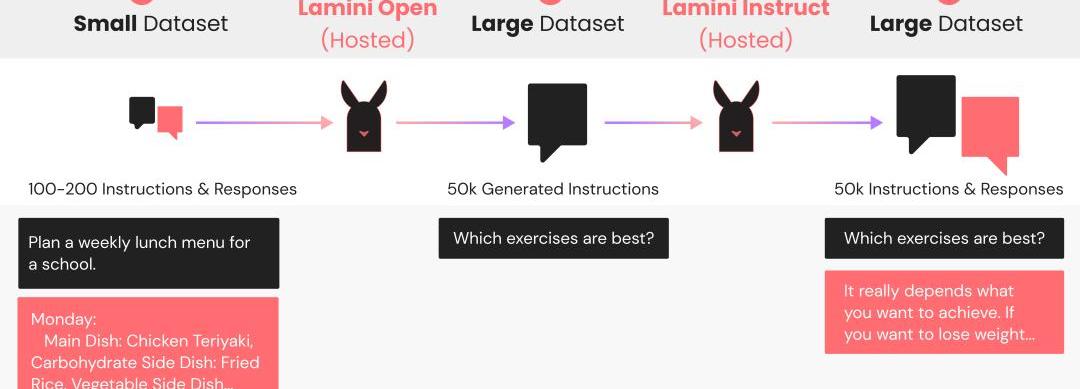

數據生成器工作原理

Lamini數據生成器是一個LLM管線,它采用原始的100多條指令的小集合,與預期的響應配對,生成50k+新的配對,靈感來自Stanford的Alpaca。這個生成管線使用Lamini庫來定義和調用LLM,以生成不同但相似的指令和響應對。

根據這些數據訓練后,你的LLM會遵循這些指示,因而得到改進。對于使用開源LLM的生成管線,研究者提供了一個很好的默認值,LaminiOpen和LaminiInstruct。

隨著每天新的LLM發布,研究者都會將默認值更新為性能最佳的模型。在目前的版本中,LaminiOpen用的是EleutherAI的Pythia,LaminiInstruct用的是Databricks的Dolly。

LaminiOpen會生成更多指令,而LaminiInstruct會生成這些指令的成對響應。

最終生成的數據集可供免費商業使用,已經通過CC-BY許可。

僅用一行代碼,就可以將Lamini庫的默認值換成其他開源或OpenAI模型。

研究者發現,OpenAI模型的平均表現更好,但它們的許可限制了將生成數據用于訓練類ChatGPT模型的商用。

對生成數據進行微調

在這個過程中,生成的數據會質量不一。

在微調之前,下一步就是將生成的數據過濾為高質量數據。

然后,Lamini會通過在這個過濾后生成的數據集上訓練基礎模型,來創建自定義LLM。

研究者已經發布了一個開源指令跟隨LLM,可以用Lamini來訓練Pythia基礎模型,生成的37k指令是從70k中篩選出來的。

顯然,Lamini庫的出現,讓迭代周期變得更快、更有效,有更多的人能夠構建模型,而不僅僅是試驗各種prompt。

團隊介紹

SharonZhou是Lamini的聯合創始人兼首席執行官。

個人主頁:https://sharonzhou.me/

她在哈佛大學獲得了計算機科學與古典文學聯合學士學位,并以最高榮譽獲得了碩士學位。

隨后,她在斯坦福大學獲得了計算機科學博士學位,師從吳恩達。

2022年,29歲的Zhou入選《麻省理工科技評論》「35歲以下科技創新35人」。

GregoryDiamos是MLPerf的聯合創始人。

他曾是百度硅谷AI實驗室的創始成員,對DeepSpeech和DeepVoice系統有貢獻。

參考資料:

https://lamini.ai/blog/introducing-lamini

Tags:MINIMINPROROMgemini女朋友為什么叫室友Mina Protocolbitopro交易所romiechain

1.一文看懂SovereignRollup運作原理人人都在談論Sovereignrollup以及它們與基于智能合約的rollup有何不同,但卻無人關注“它們實際上是如何運作的”.

1900/1/1 0:00:00似乎有一種普遍的誤解,認為以太坊只能通過L2進行擴展。我可能會因此而受到一些指責,因為我寫了太多關于L2Rollup的文章,而沒有足夠地覆蓋L1擴展路線圖,為此我道歉——在這里,我試圖糾正這個錯.

1900/1/1 0:00:00最近幾個月來,比特幣生態最大的事件就是比特幣Ordinals協議和銘文的爆發。銘文提供了一種將信息附加到比特幣交易中的新方式。用戶可以充分利用比特幣的去中心化、安全等特性.

1900/1/1 0:00:00來源丨元宇宙簡史 編寫丨元宇宙簡史主理人Fun5月9日,抖音發布了關于人工智能生成內容的平臺規范暨行業倡議,以及《抖音關于人工智能生成內容標識的水印與元數據規范》.

1900/1/1 0:00:00近期,Meme狂熱,也帶動各種“土狗幣”亂飛。不明真相的吃瓜群眾,跟著“沖土狗”,結果卻誤入“貔貅盤”,資金也無法取回。下圖則是近期一位“貔貅盤”受害者來找到Beosin求助.

1900/1/1 0:00:00在大多數領域中,“老大與老二的爭奪戰”往往都是異常激烈。主導加密領域的比特幣和以太坊亦開始了“社區共識份額”的競爭。 在大多數領域中,“老大與老二的爭奪戰”往往都是異常激烈.

1900/1/1 0:00:00